3. Funktionsweise

Soundkarten

Wie bereits im vorhergehenden Kapitel angeschnitten, verwendete der AdLib-Standard die in den 80ern sehr populäre frequenzmodulierende Synthese (FM-Synthese). Diese wurde in den frühen 70er-Jahren von Dr. John Chowning an der Universität von Stanford entwickelt und beruht auf der Erzeugung einer Sinusschwingung (Carrier) und einer aufmodulierten zweiten, dem Modulator. Wenn beide sog. Operatoren ungefähr die gleiche Frequenz haben, entstehen komplexe Wellenformen und somit Obertöne, die denen von akustischen Instrumenten sehr ähneln können. So funktionieren übrigens auch FM-Synthesizer.

Die FM-Technik bietet nahezu unbegrenzte Möglichkeiten, elektronisch Klänge zu erzeugen. Leider erweist sich der Klang vieler FM-Instrumente als zu künstlich und dünn, um den anspruchsvollen Multimedia-Jünger zu beeindrucken. Doch Abhilfe nahte mit der WaveTable-Synthese.

WaveTable Soundkarten

Bei dieser Technik versuchte man nicht mehr, das akustische Spektrum von Instrumenten synthetisch zu generieren, sondern legte das Sound -Spektrum eines Instruments und dessen entsprechende Wellenformen in einem ROM-Speicher ab, der direkt auf das Soundboard gelötet war bzw. als optionales Steckmodul nachgerüstet werden konnte.

Bei den WaveTable Soundkarten ist man von bestehenden Sounds in einem entsprechenden Daten- bzw. Hardware- Format abhängig, das Ergebnis ist von der Qualität der Wellenformen, der Speichergröße und der Anzahl der Samples pro Instrument abhängig. Darüber hinaus haben natürliche Instrumente noch weitere Besonderheiten. So kann man bei einem leise gespielten Piano das Schlagen des Hammers auf die Saite nicht hören, während sich bei lautem Spiel nicht nur diese Tatsache ändert, sondern auch weitere, subtile Änderungen im Klangbild auftreten (z.B. werden benachbarte Saiten zum Schwingen angeregt). Kurzum: gute Qualität benötigt Speicher und Rechenleistung. Sampler sowie viele Keyboards nutzen diese Technologie zur Klangerzeugung.

Audiointerfaces

Audiointerfaces ebnen den Weg für Audiosignale in den Computer und aus ihm heraus, man kann sie sich als Pförtner am Übergang der musikalischen Außenwelt zur reinen Zahlenschieberei im Rechner vorstellen.

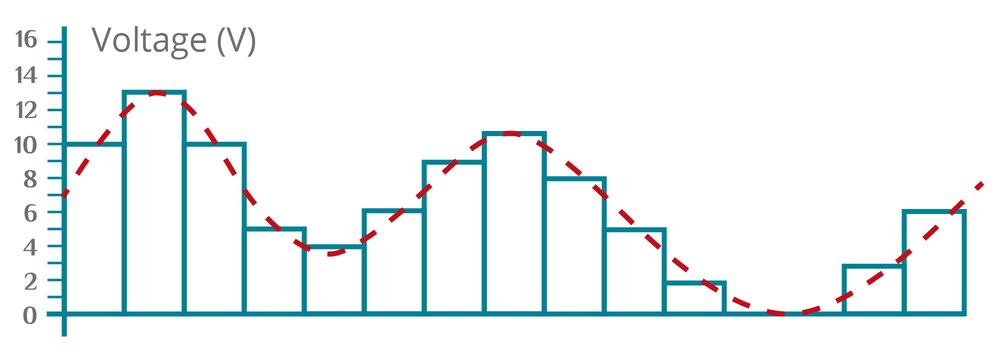

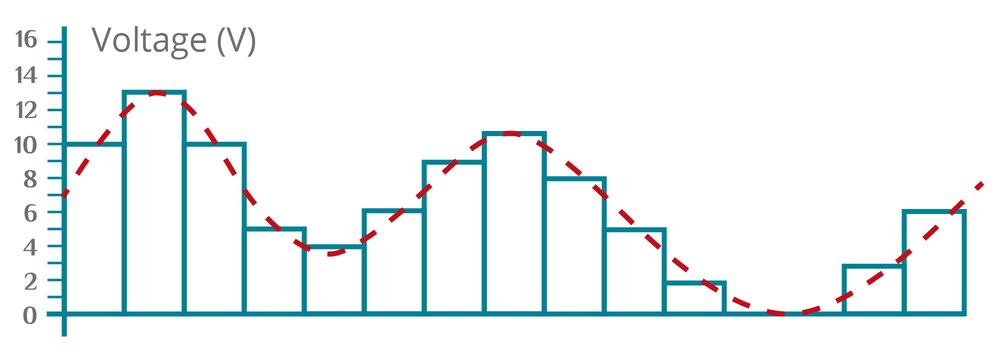

Analoge Signale muss der A/D-Wandler (Analog zu Digital) des Audiointerface ins Reich der Nullen und Einsen schleusen: In sehr kurzen Abständen wird der jeweils anliegende Pegel des Signals gemessen (z. B. bei einer Samplerate von 48 kHz eben genau 48 000 Mal pro Sekunde) und dem nächstliegenden digitalen Wert zugeordnet, den der Rechner verstehen kann. Im Gegensatz zur "analogen Unendlichkeit" kennt dieser keine fließenden Übergänge, sondern nur eine begrenzte Anzahl fester Werte (repräsentiert durch die Anzahl der Bits, mit der die Wandler arbeiten). Der kontinuierliche Pegelverlauf des analogen Signals wird so in kleinste Zeitschnipsel zu einer fortwährenden Zahlenkolonne zerlegt. Erst mit diesem digitalen Datenstrom kann der Computer etwas anfangen.

Für die Wiedergabe braucht es den umgekehrten Weg: Der D/A-Wandler (Digital zu Analog) im Audiointerface muss aus der vom Rechner kommenden Zahlenfolge wieder eine kontinuierliche Wellenform erstellen, die dem ursprünglichen analogen Verlauf so exakt wie möglich entsprechen soll.

In beiden Fällen spricht man von einer (Um-)Wandlung bzw. Konvertierung. Entsprechend werden die elektronischen Schaltkreise als Wandler bezeichnet (es haben sich auch die englischen Abkürzungen „ADC“ für Analog-Digital-Converter und „DAC“ für Digital-Analog-Converter eingebürgert). Die Qualität dieser Bausteine ist zu einem großen Teil – aber nicht ausschließlich – für die Güte des gesamten Audiointerface verantwortlich. Die maximale Samplerate alleine lässt allerdings noch keine Rückschlüsse auf die Klangqualität des Interfaces zu. Es gibt mittlerweile schon sehr günstige Interfaces die 96kHz oder mehr können, aber trotzdem nicht besonders gut klingen.

... das ankommende Signal

Digitalsignal

... wird im A/D-Wandler in kleinen Abständen ausgemessen und einem digitalen Wert zugeordnet.

| Messwert: | 10 | 13 | 10 | 5 | 4 | 6 | 9 | 10 | 8 | 5 | 2 | 0 | 0 | 3 | 6 |

| Binäre Information: | 1010 | 1101 | 1010 | 0101 | 0100 | 0110 | 1001 | 1010 | 1000 | 01011 | 0010 | 0000 | 0000 | 0011 | 0110 |

Das Digitalsignal kann als für den Computer verständliche binäre Information weiterverarbeitet werden.

Durch die Digitalisierung wird aus dem "runden" Sinus ein stufiges Signal. Diese Stufigkeit macht sich klanglich durch zusätzliche Obertöne bemerkbar. Diese Obertöne werden bei der D/A-Wandlung durch das sogenannte Reconstructionfilter wieder entfernt. Unter anderem hat auch die Qualität dieses Filters Einfluss auf den Gesamtklang des Wandlers.

Ein anderer Punkt, der für die Qualität des Audiosignals eine wichtige Rolle spielt, ist die Genauigkeit der Clock. Die Clock gibt vor, wann das nächste Sample abgetastet werden soll. Leider kann keine Uhr der Welt unendlich genau gehen. Es gibt immer minimale Abweichungen. Und bei 48 000 Samplevorgängen pro Sekunde können schon minimale Abweichung der Abtastzeit dazu führen, dass das Sample einen anderen Wert hat als es eigentlich haben sollte. Diese leichten Schwankungen der Clock werden als Jitter bezeichnet. Je nach Preisklasse des Interfaces hat der Hersteller unter Umständen viel Zeit und Geld in die Entwicklung einer Jitterarmen Clock gesteckt.

Bei digitalen Verbindungen (wie S/PDIF oder ADAT) sorgt das Audiointerface in erster Linie dafür, dass der Rechner das jeweilige Datenformat "versteht" und weiter bearbeiten kann. Da hier bereits Audiodaten in digitaler Form vorliegen, ist eine Wandlung im eigentlichen Sinne nicht mehr nötig.

Wenn mehrere Audiogeräte über eine digitale Schnittstelle miteinander verbunden werden, ist es wichtig, dass alle mit dem gleichen Clocktakt arbeiten. Wenn jedes Gerät mit seiner eigenen Clock arbeiten würde, könnte es passieren, dass das eine Gerät ein Sample sendet, obwohl das andere grade gar kein Sample erwartet oder umgekehrt. In der Praxis macht sich das als Knackser bemerkbar.